日前, Elsevier(爱思唯尔)云论坛暨络绎学术 Online 第九期线上学术会议成功举办,我们与 Elsevier 一同为大家呈现了信息技术芯片的发展与创新。

本次论坛由上海交通大学集成量子信息技术研究中心主任金贤敏教授主持,特邀上海交通大学人工智能研究院首席科学家徐雷教授、浙江大学光电科学与工程学院副院长戴道锌教授、北京大学人工智能研究院类脑智能芯片研究中心主任杨玉超教授、上海交通大学物理与天文学院副研究员唐豪、以及爱思唯尔核心内容客户顾问许靖博士,围绕信息技术芯片的基本技术原理、产品应用及未来发展展开主题分享。

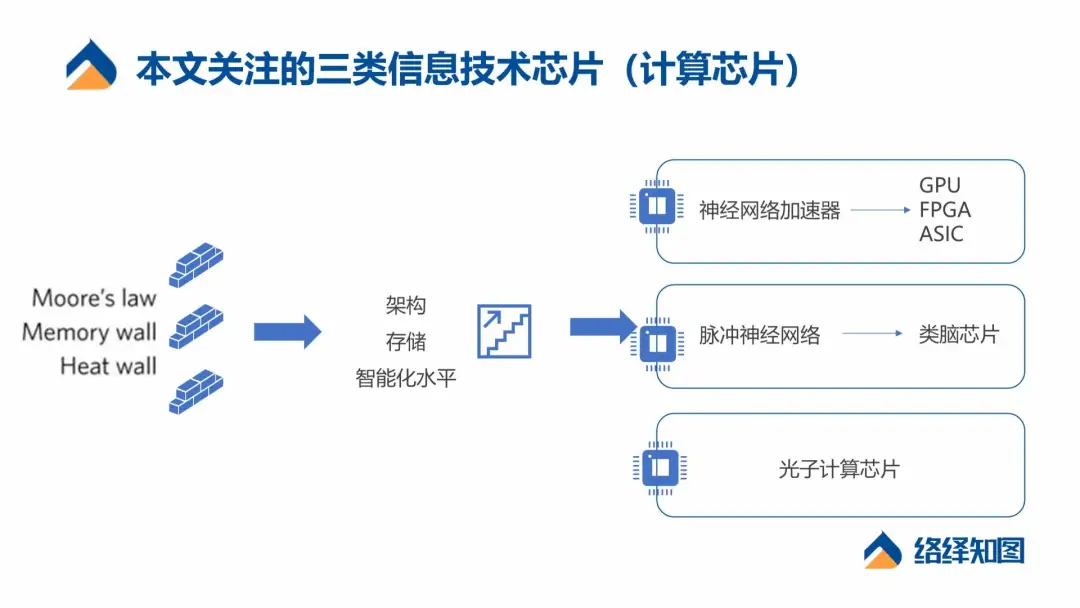

本文将结合论坛的重点内容和当前信息处理芯片的现状,对三种未来备受关注的信息技术芯片进行概念解读及产业分析。

信息技术芯片的演进,背后透射出算力的螺旋式上升

在算力需求大幅提升的背景下,信息技术芯片所承载的计算处理能力不足,来源于架构侧、智能化水平、功耗、软件能力等多方面的挑战。

最早以 CPU 为代表的计算芯片采用的依然是传统的冯·诺依曼架构,存算分离是最大的特点,也是冯诺依曼架构的瓶颈所在。在计算之前需要从存储器当中读取数据,之后再进行计算。这个过程中,功耗和延时花费在搬运数据的环节上。从单次操作来讲,大多数情况下,搬运数据需要的功耗占据了整个功耗的约 70% 。解决这个问题最直接的思路,即是实现存算一体。

同时,存储器性能的提升远远落后于计算器性能的提升。由于冯·诺依曼瓶颈和存储墙的存在,导致存算分离架构下,算力的提升面临天花板。为了解决这种困境,更多类型的非冯·诺依曼架构芯片出现,例如类脑芯片、光子芯片等。

除了架构侧的限制,智能化水平的提升也趋势计算芯片向更智能的阶段迈进。2011 年,风险投资公司 Andreessen Horowitz 的普通合伙人 Marc Andreessen 在《华尔街日报》上发表了一篇非常有影响力的文章,名为“ Why Software Is Eating the World-软件为何在吞噬世界”。十年后的今天,我们正站在“ Deep Learning is Eating the World-深度学习正在吞噬整个世界”的节点。

基于人工智能的自然语言处理、图像识别和自动驾驶的技术进步,是以消耗计算资源和能源为代价的。工程师和计算机科学家正在付出巨大的努力,以找出更有效地训练和运行深度神经网络的方法。这也是未来计算芯片升级和演化的主要目的,为了让其更好地执行 AI 计算。

第三代神经网络技术预计向类脑脉冲神经网络技术演进,对更高智能水平的人工智能技术的需求,也驱使计算平台的架构升级和智能化升级。

不难发现,人脑是自然界中存在的典型高智能、低功耗的单体计算平台。类脑芯片则是典型的存算一体、高度智能化的计算架构。全球范围内对类脑智能和类脑芯片的研究,已经是非常重要的前沿课题。